L'organisation du projet

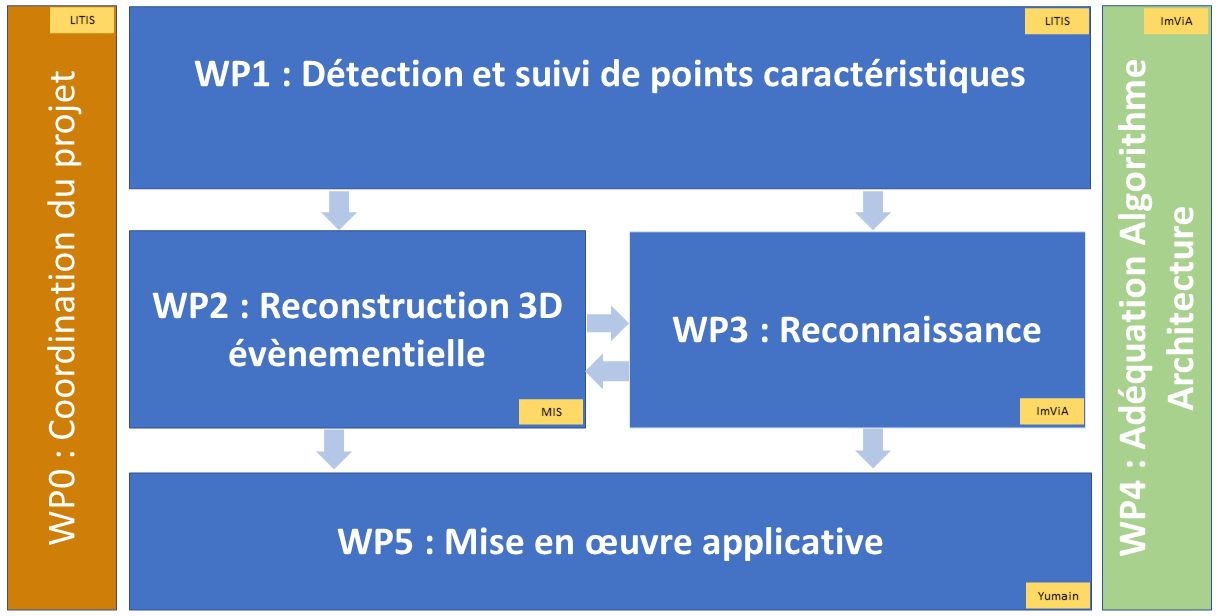

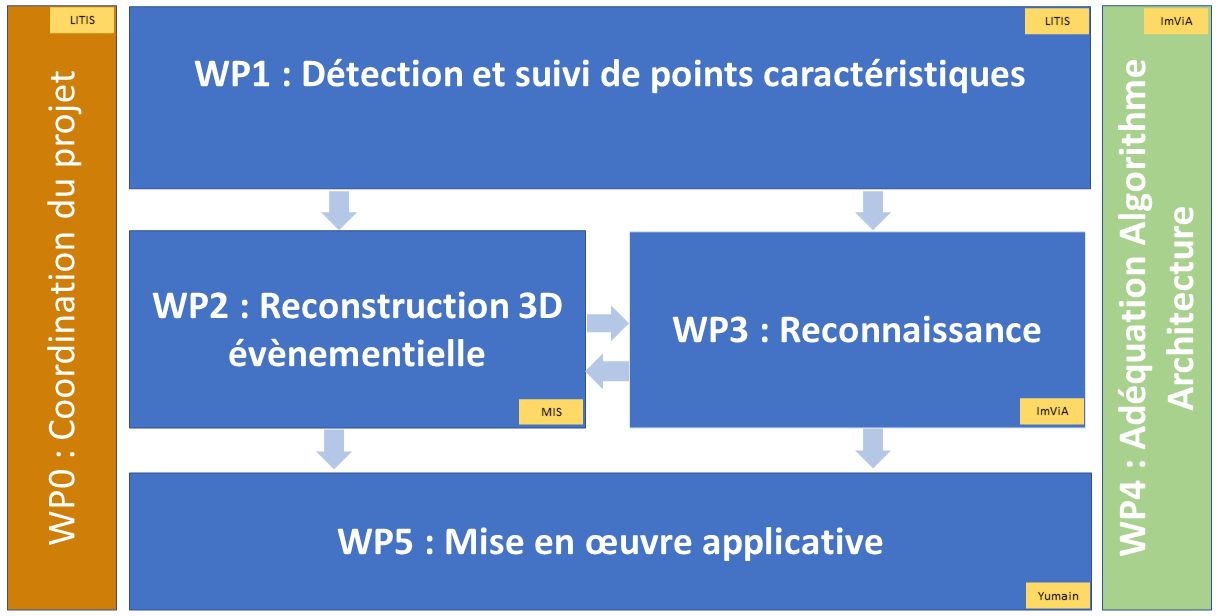

La figure ci-dessous illustre de façon synthétique l’organisation générale de ce projet et les relations entre les workpackages.

La figure ci-dessous illustre de façon synthétique l’organisation générale de ce projet et les relations entre les workpackages.

Responsable : LITIS

Cette tâche a pour but de veiller à l’organisation du projet au niveau technique, financier et administratif. Cette tâche sera menée par le LITIS sur toute la durée du projet afin de veiller à son bon déroulement par rapport au planning prévu, au maintien de sa dynamique et à l’implication de tous les partenaires. Des points d’avancements seront faits tous les 3 mois et donneront lieu à des comptes-rendus. Le coordinateur sera responsable de la production des rapports intermédiaires d’avancement et du rapport final. Il aura aussi un rôle d’interface avec l’ANR. Des outils de communications internes et externes (site internet) seront également mis en place.

Responsable : LITIS

Le premier objectif de ce workpackage est d’extraire des points caractéristiques et leurs descripteurs qui soient le plus possible invariants au mouvement. Il s’agit encore d’un challenge avec la vision évènementielle puisque les évènements générés sont dépendants du mouvement de la caméra. Ces points caractéristiques alimenteront les travaux du WP2 puisqu’ils serviront à estimer le mouvement de la caméra et à reconstruire les points en 3D par stéréovision, par SLAM et en utilisant la multi-modalité avec le lidar. Les descripteurs proposés seront également utilisés dans le cadre du WP3 puisqu’ils pourront servir pour les algorithmes de reconnaissance de lieu. Enfin, ils serviront également au WP5 pour calibrer le système qui sera développé. Le second objectif est de proposer des méthodes d’estimation du flot optique adaptées à notre contexte applicatif, là où la majorité des méthodes de l’état de l’art imposent des contraintes sur la scène ou le mouvement de la caméra (flot optique uniforme). L’estimation de ce flot optique permettra de segmenter les objets en mouvements, objets qui seront ensuite reconstruits en 3D (WP2) et reconnus (WP3).

Responsable : MIS

Dans ce WP, l’objectif consiste à produire une représentation tridimensionnelle de l’environnement du véhicule afin de pouvoir d’une part le localiser et d’autre part identifier les objets mobiles. La 3D sera obtenue soit par vision stéréo-évènementielle soit par association d’une caméra évènementielle avec un Lidar. Dans les deux cas, les verrous scientifiques seront d’associer les données provenant des deux capteurs, d’estimer la pose, de détecter et suivre les objets mobiles.

Responsable : ImViA

Les techniques d’apprentissage profond basées sur des réseaux convolutifs sont aujourd’hui de formidables outils pour accomplir des tâches de très haut niveaux en vision par ordinateur. Néanmoins, elles restent peu efficaces dans le cas des caméras évènementielles puisque les filtres convolutifs ne sont pas nécessairement adaptés à ce type de caméras à cause de la nature même de l'acquisition. En effet, le filtrage convolutif suggère une interdépendance spatiale entre les pixels voisins qui n’est pas vérifiée sur ces images et nécessite des calculs très couteux en temps de calcul alors que peu de pixels sont activés. C’est pourquoi ce WP a pour objectif de revisiter les approches d’apprentissage profond pour des problématiques de reconnaissances d’objets et/ou lieux tout en tirant partie de la spécificité de ces images. WP3 sera en lien fort avec les études menées dans WP1 et WP2.

Responsable : ImViA

La complexité sans cesse croissante des applications de vision artificielle rend de plus en plus difficile la possibilité d’obtenir simultanément efficacité algorithmique et rapidité de traitement. Cet aspect est d’autant plus crucial dans le contexte du véhicule autonome pour lequel une perception 3D fiable et rapide est requise. Pour cela, dans WP4, nous proposons d’adopter une démarche systématique d’Adéquation Algorithme Architecture reposant sur le paradigme d’Approximate Computing. L’objectif est de réduire significativement la complexité des algorithmes tout en garantissant des performances similaires, compatibles avec les exigences applicatives du véhicule autonome. Les solutions retenues seront évaluées sur une architecture matérielle comprenant un processeur GPU embarqué (typiquement NVIDIA Xavier) couplé aux différents capteurs utilisés dans le projet (1 ou 2 caméras évènementielles et Lidar). En collaborant activement avec les autres WPs, WP4 s’affiche comme transversal avec comme ambition d’élaborer une méthodologie scientifique commune applicable aux différents algorithmes développés dans les WP1 à WP3 et de proposer au final des solutions technologiques réplicables pouvant satisfaire les contraintes temps réel du WP5.

Responsable : YUMAIN

Les objectifs de ce workpackage sont multiples :