Contexte

Le véhicule autonome est un des enjeux majeurs de la mobilité de demain. Dans un futur proche

les usagers auront accès à des flottes de véhicules autonomes partagés.

La dynamique instaurée par le véhicule autonome

profite à l'amélioration des capteurs.

La taille des lidars diminue, leur portée augmente et leur coût baisse. De nouvelles technologies émergentes (Lidars solid-state) promettent encore une

miniaturisation et de s'affranchir des parties mécaniques pour une meilleure intégration dans le

véhicule.

Concernant les caméras, de nouvelles technologies ont émergé ces dernières années : caméras à temps de vol, caméras plénoptiques, caméras omnidirectionnelles et caméras évènementielles. Ces caméras semblent promises à un bel avenir car elles permettent d’obtenir des informations complémentaires aux caméras classiques : informations de profondeur, multi-vues, augmentation du champ de vision, etc.

Objectif

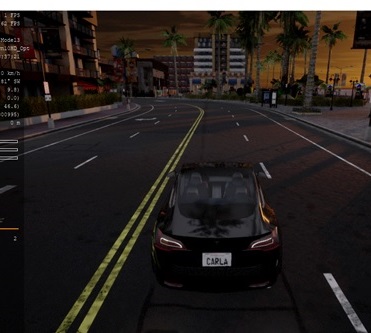

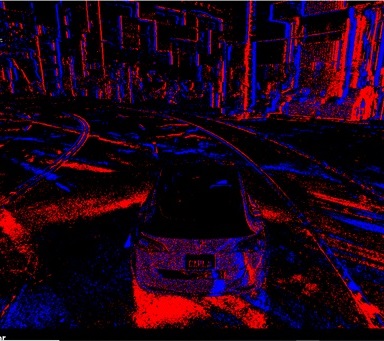

L'objectif principal de ce projet est l'exploitation d'un capteur en rupture technologique avec les solutions existantes pour la perception du véhicule autonome : la caméra évènementielle. La caméra évènementielle, aussi connue sous le nom de caméra neuromorphique ou Dynamic Vision Sensor (DVS), semble particulièrement intéressante pour le véhicule autonome. Il s’agit d’un capteur bio-inspiré qui, au lieu de capturer des images statiques - alors que les scènes sont dynamiques - à une fréquence fixe, mesure les changements d’illumination au niveau des pixels et de façon asynchrone. Les propriétés de cette caméra sont particulièrement intéressantes pour la perception des objets rapides et dans des conditions d'illuminations difficiles. La perception pour le véhicule autonome doit de plus être tri-dimensionnelle pour pouvoir localiser les différentes entités (autres véhicules, motos, cyclistes, piétons) et déterminer s'il y a un danger ou si la situation est normale.

Approche

Notre approche s'intéresse à la thématique novatrice de la 3D évènementielle pour le véhicule autonome.

Plusieurs pistes seront explorées pour retrouver l'information de profondeur : le SLAM (Simultaneous Localization and

Mapping), la DATMO (Detection and Tracking of Moving Obstacles) par stéréovision évènementielle et la fusion multi-modale caméra

évènementielle - lidar.

Une étape de reconnaissance sera également nécessaire afin de permettre au véhicule autonome de prendre la décision la plus adaptée en fonction de la situation. Les approches les plus performantes à l’heure actuelle sur les images classiques (CNN, etc) ne sont pas adaptées à la structure des données fournies par la caméra évènementielle, de nouvelles approches doivent donc être trouvées.

Enfin, l’aspect temps réel est crucial pour ne pas perdre les avantages des caméras évènementielles, une démarche systématique d’Adéquation Algorithme Architecture (AAA) sera donc mise en place afin de de réduire significativement la complexité des algorithmes tout en garantissant des performances similaires, compatibles avec les exigences applicatives du véhicule autonome.

Perception pour le véhicule autonome

Caméra évènementielle mobile dans une scène dynamique

Détection et suivi de points caractéristiques

Un des premiers challenges consiste à trouver des points d'intérêts et à leur associer des signatures pour pouvoir les suivre dans le temps (feature detection and tracking). Cette tâche est essentielle pour un grand nombre d'algorithmes de vision par ordinateur : odométrie visuelle, stéréovision, flot optique, segmentation et reconnaissance d'objets.

SLAM/DATMO par stéréo event

Le SLAM visuel permet de construire une carte de l'environnement autour du véhicule et de nombreuses méthodes performantes ont été développées ces dernières années. SLAM-DATMO vise à construire la carte statique de la scène et aussi à détecter les objets en mouvement pour les suivre et les localiser.

Multimodalité caméra-évènementielle/lidar

La stratégie actuelle des différents acteurs du domaine consiste à fusionner les informations issues de capteurs ayant des modalités différentes (caméras, lidar, radar). Il faut alors mettre en correspondance les informations issues de ces différentes modalités qui peuvent être de nature totalement différente: nuages de points 3D, images 2D, etc.

Reconnaissance d'objets à l'aide de caméras évènementielles

La reconnaissance d'objets en vision par ordinateur s'est développée avec les méthodes d'apprentissage profond. Pour les caméras évènementielles, les architectures neuronales doivent d'être repensées et adaptées. Nous proposons de développer des nouvelles techniques fusionnant les méthodes spatiales de type convolutif (CNN) avec les méthodes impulsionnelles (SNN).